Character.AI 突破性技术: 实时 AI 角色视频互动

- 2025-07-05 23:13:38

- 135

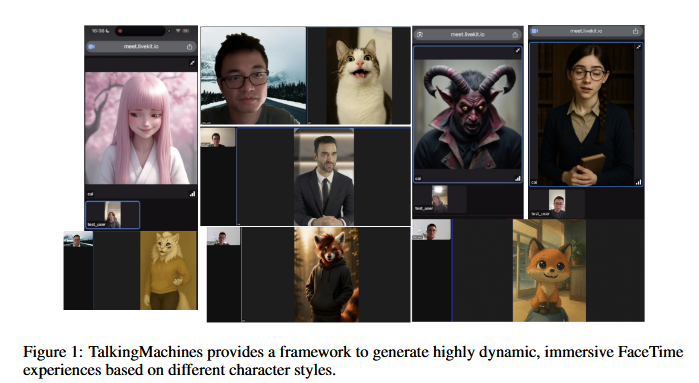

IT之家7月5日消息,AI聊天机器人平台Character.AI发布研究论文和视频演示,展示了名为TalkingMachines的自回归扩散模型,让AI角色互动更加逼真。

该模型尚未部署在Character.AI平台上,根据研究论文和视频演示,用户只需要输入一张图片和声音信号,该模型就能实现类似FaceTime的通话视觉互动。

该模型基于DiffusionTransformer(DiT)技术,本质上是一种能够从随机噪声中创建详细图像的“艺术家”,并不断优化图像直至完美。Character.AI所做的就是让这一过程变得极其迅速,达到实时效果。

TalkingMachines模型采用了流匹配扩散(Flow-MatchedDiffusion)、音频驱动的交叉注意力(Audio-DrivenCrossAttention)、稀疏因果注意力(SparseCausalAttention)和不对称蒸馏(AsymmetricDistillation)等多种关键技术。

其中流匹配扩散技术通过训练大量动作,包括细微的面部表情和更夸张的手势,确保AI角色动作更加自然。音频驱动的交叉注意力技术则让AI不仅能听到单词,还能理解音频中的节奏、停顿和语调,并将其转化为精确的口型、点头和眨眼。

稀疏因果注意力技术让Character.AI能够以更高效的方式处理视频帧,而不对称蒸馏技术则让视频能够实时生成,营造出类似FaceTime通话的效果。

Character.AI强调,这一研究突破不仅仅是关于面部动画的,它是朝向实时互动的音频视觉AI角色迈出的一步。该模型支真实感人类、动漫和3D虚拟形象等多种风格。

IT之家附上参考地址

- 上一篇:女子称丈夫因离婚纠纷毒死亲生儿女

- 下一篇:泰方回应军官在国防部宴请中国